Moshi:Kyutai实验室推出的实时音频多模态模型

485

485

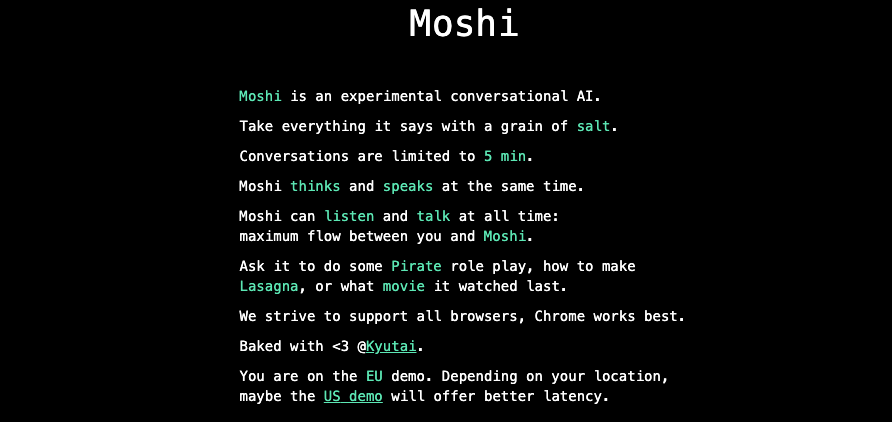

Moshi 是一款由法国 AI 实验室 Kyutai 发布的实时音频多模态模型,该模型在多个方面展现出了强大的功能和潜力。Kyutai是一个仅有 8 人的非营利性AI研究机构,他们在短短 6 个月内完成了Moshi的开发工作。

Moshi提供了一种更自然、更快速的交互体验,特别是在需要即时反馈和情感理解的场景中。其多模态能力和对情感的支持能够增强用户体验,使得人机对话更加丰富和人性化。

实时交互能力:Moshi具备实时聆听和实时交谈的能力,其低延迟特性(低于 300ms,实时因子为 2 时可达 160 ms)使得用户在与Moshi交流时几乎感受不到延迟。Moshi 可以同时处理两个音频流,实现同时聆听和说话,这种实时交互基于文本和音频混合的联合预训练。

多模态功能:Moshi不仅限于文本和语音的交互,还具备情感识别和表达的能力。它可以模仿快乐、悲伤等 70 种不同情绪和说话风格,使对话更加自然和丰富。Moshi 还能进行角色扮演,如以海盗身份讲述冒险故事,展现了其强大的多模态理解和表达能力。

开源与可用性:Moshi是一个开源模型,用户可以通过官网轻松体验其功能。Moshi 单次对话的限制为 5 分钟,但用户可以随时暂停对话并继续,同时支持下载对话视频或语音。

技术基础:Moshi 于一个 7B 的多模态大型语言模型和双通道 I/O系统运行。其核心是一个处理语音输入和输出的70亿参数多模态语言模型,采用 Helium 7B 作为基础文本语言模型,并与文本和音频编解码器联合训练。Moshi的语音编解码器基于Kyutai内部的Mimi模型,具有300倍的压缩系数,可捕捉语义和声音信息。

情感与风格支持:Moshi 的文本转语音引擎支持70种不同的情绪和风格,这些是根据一位名叫 Alice 的有执照的声音达人录制的 20 个小时的音频进行微调的。Moshi 的微调过程涉及使用文本到语音(TTS)技术转换的 100,000 个“口语风格”的合成对话,以增强其情感表达和风格模拟的能力。

Moshi作为一款实时音频多模态模型,在实时交互、多模态功能、开源与可用性等方面都展现出了强大的潜力和价值。尽管Moshi在多个方面表现出色,但其信息可靠性仍需加强。Kyutai实验室强调负责任的AI使用,并计划通过嵌入水印等技术手段来检测AI生成的音频。

The End

发表你的想法 +100 宝石 获取宝石,兑换应用

点击头像登录后发表你的评价

*你在多大程度上愿意向你的朋友推荐这个产品?

关于这个产品,你有什么想说的呢?你最喜欢应用什么地方?

你已经发表想法了

感谢你的提交 ❤